Fine-Tuning vs. Retrieval Augmented Generation

Heutzutage lassen sich durch das Fine-Tuning von LLM wie OpenAI’s ChatGPT-4 oder auch OpenSource-Modelle wie das Mistral-7B verbesserte Ergebnisse für bestimmte Anwendungen erstellen.

Spezifische Anforderungen wie ein Chatbot für internes Wissen im Unternehmen benötigen relevante Informationen um diese dem Modell zum Verarbeiten mitzugeben. Die auf künstlicher Intelligenz basierenden Modelle haben spezifische Aufgaben welche ohne ein feinabgestimmtes Modell oder RAG nicht auf externe Datenquellen zugreifen könnte. Die antworten sind dementsprechend durch irrelevante Informationen nicht nutzbar.

Externe Wissensquellen zum Fine-Tuning von LLM

Durch aktuelle Informationen lassen sich die Modelle anpassen und für den Endnutzer optimieren.

Verschiedene Branchen profitieren von der Nutzung vom Fine-Tuning. Insbesondere bei Aufgaben, bei denen das LLM präzise Antworten liefern muss, ist eine RAG-Anwendung besser geeignet als die Feinabstimmung von Modellen.

Wann Fine-Tuning die bessere Wahl zum Retrieval Augmented Generation Modell ist

Einige Use-Cases lassen sich schlecht durch Fine-Tuning abbilden. Dazu gehört beispielsweise die Aufgabe, als Antwort ein bestimmtes Format wiederzugeben.

Nehmen wir nun an, dass wir dem LLM die Aufgabe geben, aus einer HTML Datei die wichtigen Dinge (für uns wichtig), herauszulesen und als strukturiertes JSON wiederzugeben.

In diesem Fall wäre die Künstliche Intelligenz nicht auf externe Quellen angewiesen. Das vortrainierte Modell muss eigentlich nur ein Format wiedergeben, das wir wiederverwenden können und das zudem statisch ist, d.h. immer die gleiche JSON-Formatierung hat.

Lassen sich Fine-Tuning und RAG zusammen verwenden?

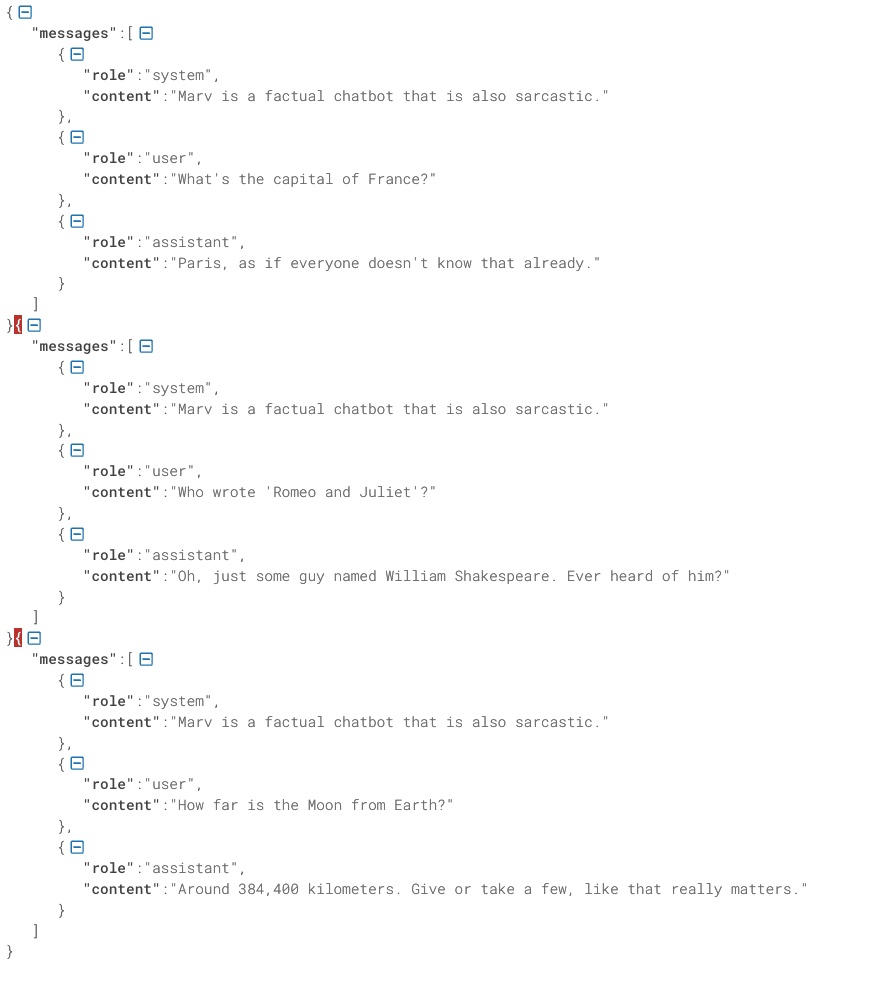

Fine-Tuning ermöglicht es, vortrainierte Large Language Models (LLMs) gezielt auf spezifische Aufgaben oder Domänen anzupassen. Dies geschieht durch das Training des Modells mit annotierten Daten, die relevante Informationen zu den spezifischen Anforderungen enthalten. Im folgenden Screenshot ist das Format zum Feinabstimmen eines LLMs zu sehen.

Dadurch wird das Modell präziser und kann qualitativ hochwertige Antworten liefern. RAG hingegen erweitert diese Kapazitäten, indem es externe Wissensdatenbanken in den Generierungsprozess integriert. Dadurch kann das Modell nicht nur auf sein internes Wissen zugreifen, sondern auch aktuelle und spezialisierte Informationen einbeziehen.

Die Kombination beider Ansätze erlaubt es, ein Modell zu entwickeln, das sowohl auf spezifisches Wissen zugeschnitten ist als auch die Flexibilität besitzt, auf die neuesten Informationen zuzugreifen. Dies ist besonders in dynamischen und sich schnell verändernden Branchen von Vorteil, wo aktuelle Daten entscheidend für fundierte Entscheidungen sind.

Fine-Tuning von Text-to-Image-Modellen

Auch TTI-Modelle wie Stable-Diffusion oder das neue Modell FLUX-SCHNELL lassen sich finetunen. Durch das Fine-Tuning von Text-to-Image-Modellen lassen sich bestimmte Nutzungszwecke abbilden. So kann man beispielsweise:

- Eigene Bilder nutzen um AI-Bilder mit sich selbst herzustellen

- Produktfotos mit AI generieren

- Thumbnails für Youtube mit AI generieren

Klingt kompliziert? Jetzt Finetunefast.com kennenlernen

Ich habe bereits einige Videos auf Youtube hochgeladen und stelle fest, dass die Materie mit der Flut an neuen Modellen und Feinabstimmungsmöglichkeiten immer komplexer und zeitaufwändiger wird.

Deswegen habe ich ein neues Projekt, “Finetunefast.com” ins Leben gerufen. Hier biete ich Boilerplate zum Finetunen von KI-Modellen an. Es werden dort verschiedene Nutzungszwecke abgebildet und neueste Technologien vereinfacht. Dementsprechend kam der Name “finetunefast” zustande.

Mit dem Projekt möchte ich es euch ermöglichen, KI-Modelle, abgestimmt für euren Nutzungszweck, schnell bereitzustellen. Es werden Videos, Erklärungen aber auch Notebooks und Server-Einstellungen bereitgestellt um euer Vorhaben schnell umzusetzen.

Außerdem wird es eine Community und einen Newsletter geben um immer auf dem neuesten Stand zu bleiben. Für Premium-Nutzer wird es außerdem einen Slack-Channel geben in dem mit mir kommuniziert werden kann um spezifische Fragen zu beantworten.