Das Finetuning von Large Language Modellen (LLMs)

Die meisten kennen Large Language Modelle unter dem Synonym ChatGPT. Hinter ChatGPT steht ein LLM welches Ihnen sämtliche Fragen beantworten kann und für viele verschiedene Zwecke sehr hilfreich ist. Man kann über den sogenannten System-Prompt verschiedene Dinge erreichen und die Antworten eines LLMs generell über geeignete Prompts verbessern. So kann man beispielsweise auch über AIxplora einen eigenen Chatbot mit interem Wissen betreiben.

Doch für manche Nutzungszwecke reicht die Nutzung von geeigneten Prompts und Systemeinstellungen nicht. Nun kommt das sogenannte Finetuning ins Spiel.

Sind Sie auf der Suche nach einem KI-Spezialisten, der Sie in Sachen LLM-Finetuning und RAG-Anwendungszwecke beraten kann?

Kontaktieren Sie mich bitte gerne!

Finetuning beim LLM

Das Trainieren eines LLMs kostet meistens mehrere Millionen Euro - laut Sam Altman kostete das Training von ChatGPT-4 beispielsweise 100 Millionen USD. Für ein kleines Unternehmen fallen aufwendige Trainings deshalb schonmal komplett raus. Durch Feintuning können sehr gute Ergebnisse erzielt und ein LLM angepasst werden. So können kleine Open-Source Modelle mit eigenen Daten getuned werden.

Das Finetuning erlaubt mehrere Nutzungszwecke, man sollte dennoch vorab entscheiden ob es sich für den Nutzungszweck anbietet. Es gibt auch Methoden wie das Retrieval-Augmented Generation (RAG), bei welchem Vektordatenbanken genutzt werden, um dem LLM relevante Informationen zur Verfügung zu stellen, auf wessen Basis die Antwort des LLMs gemacht werden soll.

Dementsprechend sollte man für wissensintensive Aufgaben ein RAG-System in Kombination mit dem LLM in Betracht ziehen. Die Wissensdatenbank und die Methodik zur Indexierung der Vektoren ist für den Erfolg der Anwendung verantwortlich.

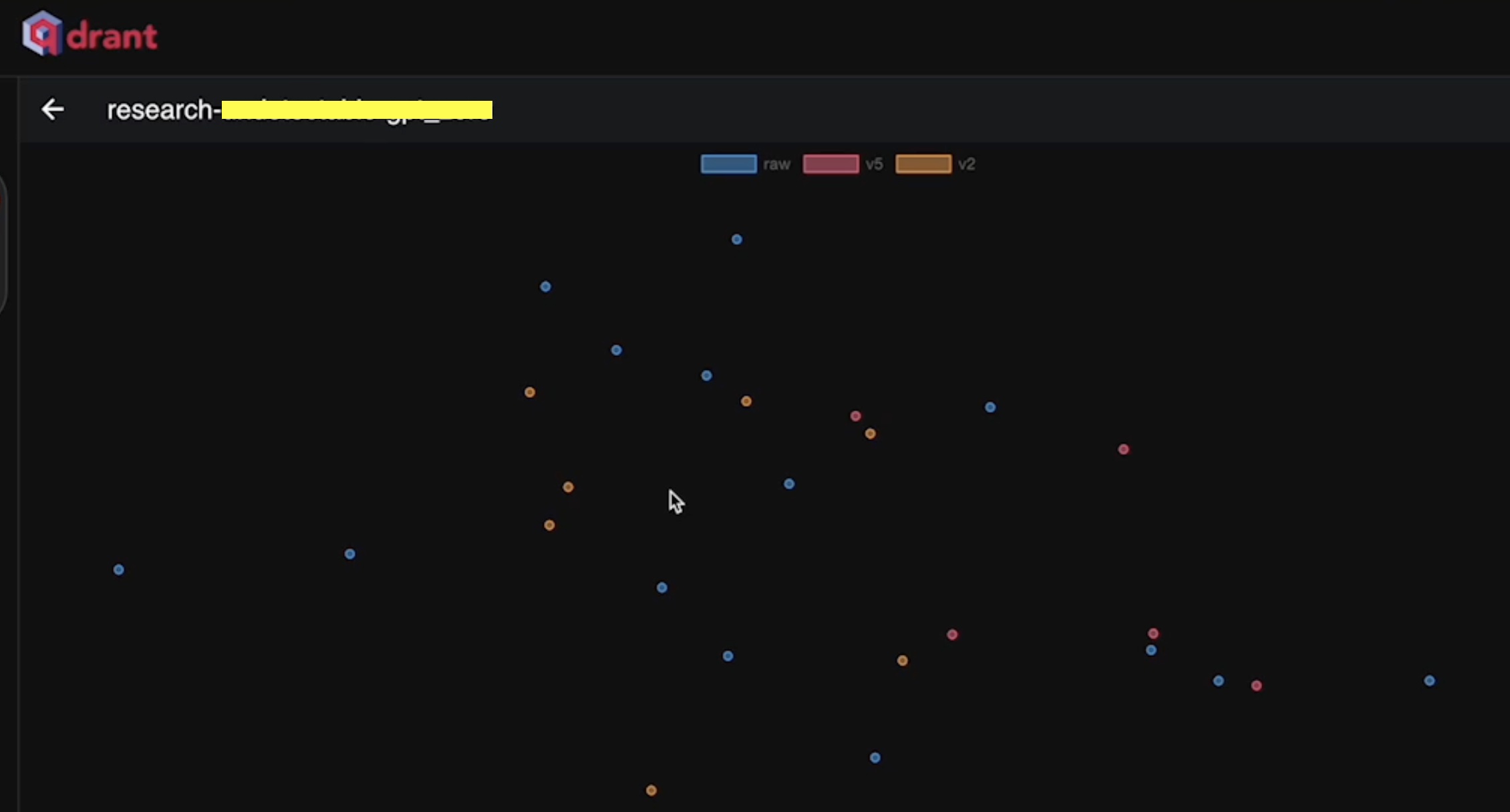

Im nachfolgenden Bild sieht man die 2D-Darstellung verschiedener Vektoren bei einem Research Task für eine RAG-Anwendung.

Wann bietet sich Finetuning an?

Die Anwendung vom Finetuning bietet sich beispielsweise an, wenn das LLM ein gewisses Fachjargon übernehmen soll. Auch bei begrenzter Datenverfügbarkeit bietet sich Finetuning gut an. Es gibt verschiedene Möglichkeiten wie man das LLM trainiert.

Das Finetuning bietet sich auch zur Reduzierung der Verzerrung von Ethiken an. Dies setzt sorgfältig erzeugte Datensätze voraus.

Die verschiedenen Finetuning Möglichkeiten und Prompt Lerntechniken

Es gibt One-Shot-, Zero-Shot -und Few-Short-Learning. Few-shot- und One-shot-Lerntechniken sind besonders wertvoll für spezialisierte Anwendungen, bei denen die Verfügbarkeit von Trainingsdaten begrenzt ist oder schnell auf neue Situationen reagiert werden muss, ohne dass ein vollständiges Training erforderlich ist. Zu den Herausforderungen dieser Ansätze gehören der Bedarf an fortschrittlicheren Modellen und Algorithmen, die in der Lage sind, effektiv aus sehr begrenzten Datenmengen zu lernen, und die Gefahr der Überanpassung, bei der die Modelle zu sehr auf die wenigen Trainingsbeispiele spezialisiert werden und ihre Generalisierungsfähigkeit verlieren.

Beim Finetunen lässt sich generell, sehr stark vereinfacht, sagen dass ein Modell bei jeder Iteration vergisst und das Verhalten angepasst wird.

Wie funktioniert das Finetuning?

Finetuning kann mit mehreren Open-Source Libraries, mittlerweile schon auf sogenannter Consumer-Hardware vorgenommen werden. Cloud-Services bieten aber mittlerweile auch GPUs an, um LLMs zu finetunen.

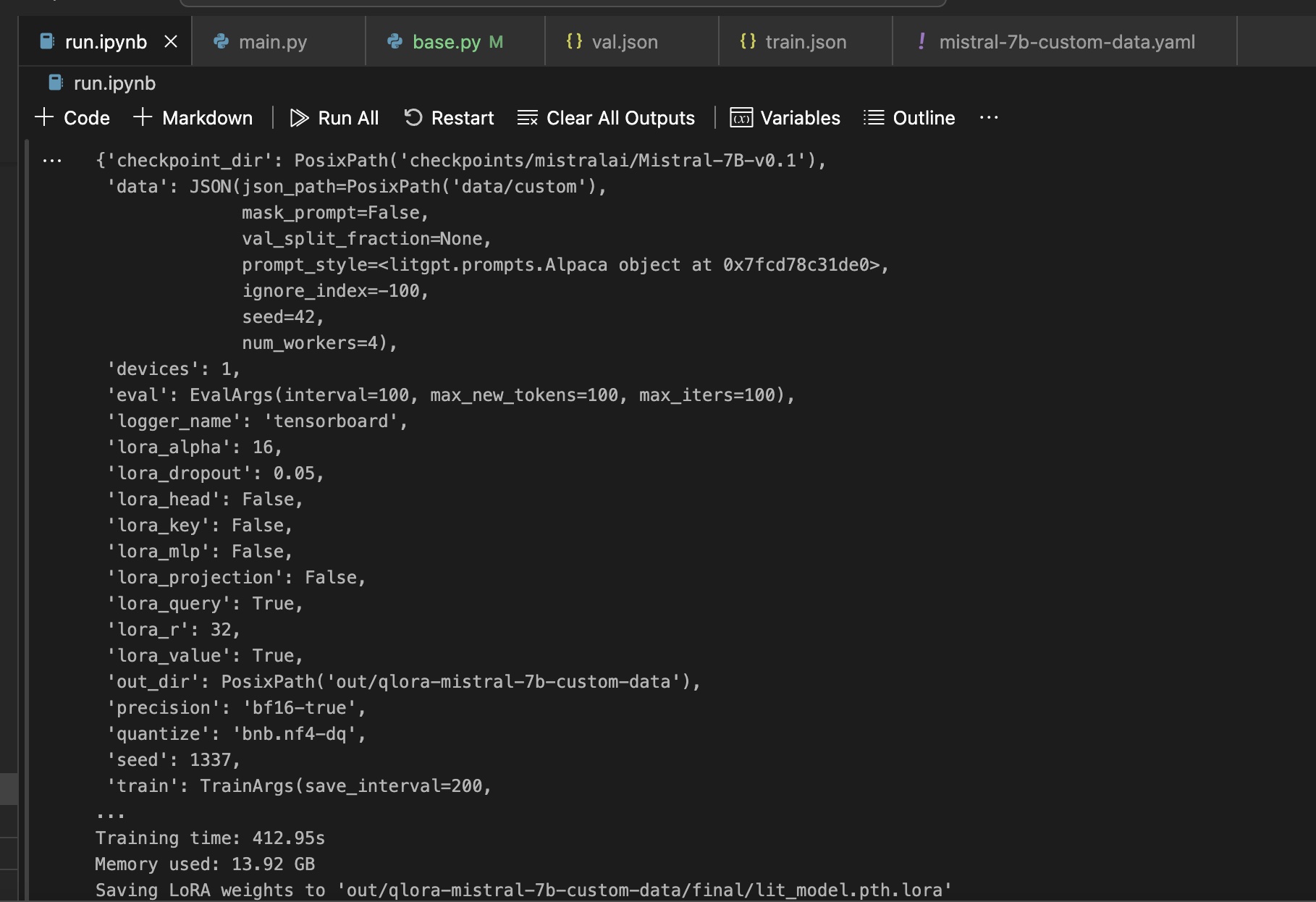

Im nachfolgenden Bild sieht man, wie ein Mistral-7B-v0.1 Model getuned wurde um den Ansprüchen eines Kundenwunsches zu entsprechen.

Können feingetunte LLMs lokal gehostet werden?

Eine Frage die ich häufig beantworten muss ist die, ob LLMs welche finegetuned sind auch lokal genutzt werden können. Die Antwort ist ja, je nach Model wird jedoch viel Grafikkartenleistung vorausgesetzt.

Als Consultant für LLMs kann ich Sie hierzu bestens beraten und mich um die Einrichtung und das Deployment kümmern. Mit einem lokalen Hosting des LLMs kann sichergestellt werden, dass Ihre Daten das Unternehmen nicht verlassen.

Verschiedene Finetuning Methoden

Beim Finetuning gibt es verschiedene Techniken, eine momentan bekannte Finetuning Methode ist LoRA und QLoRA. Die Methoden sind für die Speichereffizienz besonders bekannt geworden. Zum Paper der Low-Rank Adaption von Large Language Modellen geht es hier